IBM增加噪音以提高AI在模拟存储器上的准确性

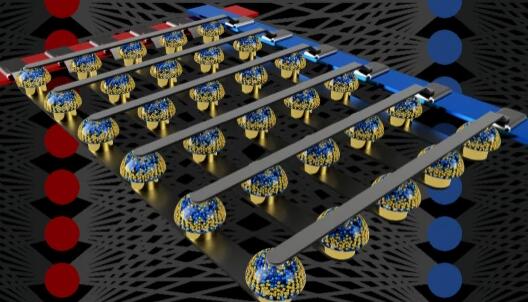

在研究发表在本周的杂志自然沟通,研究人员在IBM苏黎世实验室,瑞士声称已经开发出了实现能源效率和精度高,使用相变存储器的机器学习工作负载的技术。通过使用基于电阻的存储设备来利用内存中的计算方法,它们的方法与用于存储和计算数据的隔间相结合,在此过程中大大降低了有功功耗。

许多现有的AI推理设置在物理上拆分了内存和处理单元,导致AI模型存储在片外内存中。这会增加计算开销,因为必须在各个单元之间对数据进行混洗,这会减慢处理速度并增加用电量。IBM的技术表面上解决了相变存储器的问题,相变存储器是一种非易失性存储器,比常用的闪存技术要快。这项工作如果被证明具有可扩展性,则可以为在无人机,机器人,移动设备和其他受计算限制的设备中运行AI的强大硬件铺平道路。

正如IBM团队所解释的那样,相变存储设备面临的挑战是它趋向于引入计算误差。那是因为它本质上是模拟的。由于可变性以及读写电导噪声,其精度受到限制。

研究提出的解决方案需要在软件中的AI模型训练期间注入额外的噪声,以提高模型的弹性。结果表明它是成功的-在将训练后的权重(即,用于转换输入数据的参数)映射到噪声后,训练ResNet模型的噪声在流行的CIFAR-19数据集上的准确度达到93.7%,在ImageNet上的top-1准确度达到71.6%。相变存储器组件。此外,在将特定模型的权重映射到原型芯片中的723,444个相变存储设备上之后,在一天的过程中,精度保持在92.6%以上。研究人员声称这是一个记录。

为了进一步提高精度随时间的保持性,该研究的合著者还开发了一种补偿技术,该技术可以在推理过程中定期校正激活函数(确定模型输出的方程式)。他们说,这导致硬件精度提高到93.5%。

同时,该团队使用模拟相变存储组件对训练机器学习模型进行了实验。他们报告说,使用混合精度体系结构,他们设法在几种类型的小规模模型上实现了“软件等效”的准确性,包括多层感知器,卷积神经网络,长期短期记忆网络和生成对抗网络。 。最近在《神经科学前沿》上发表的一项研究中详细介绍了训练实验。

IBM在该领域的最新工作是在引入用于AI培训的相变存储芯片之后。在公司仍处于研究阶段的同时,公司研究人员证明了该系统可以将重量数据存储为电荷,每平方毫米的计算量是图形卡的100倍,而功耗却低280倍。

IBM表示:“在一个越来越多的时代向基于AI的技术(包括物联网电池供电的设备和自动驾驶汽车)过渡的时代,此类技术将受益于快速,低功率且可靠的DNN推理引擎,”在一份声明中。“我们研究中开发的策略显示出实现准确的AI硬件加速器架构以节能方式支持DNN训练和推理的巨大潜力。”