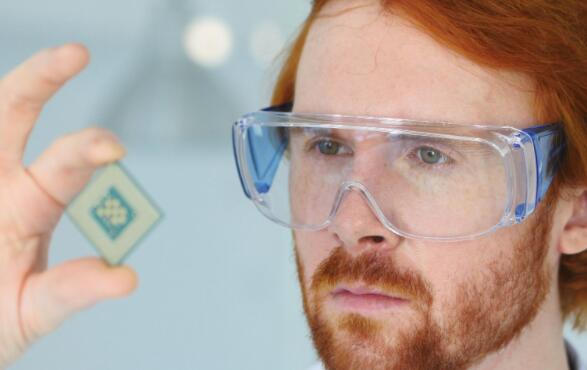

亚马逊的Inferentia AI芯片已经准备就绪 现在可以为Alexa服务提供支持

电子商务和云计算巨头Amazon.com(NASDAQ:AMZN)刚刚宣布,流行的Amazon Alexa数字助理运行在Amazon自己的硬件上,而不是由Nvidia设计的芯片(NASDAQ:NVDA)。在11月12日针对亚马逊Web服务(AWS)开发人员的博客文章中,技术推广员Seb Stormarcq说,Alexa的机器学习工作负载的“绝大部分”现在运行在亚马逊的AWS Inferentia芯片上。

什么是新的?

需要明确的是,您可能在假期购买的Amazon Echo设备和其他Alexa驱动的设备没有发生变化。重大转变发生在Alexa服务的后端,在那里数据被发送到AWS云系统进行最终处理。Inferentia被明确设计为运行神经网络软件,这是Alexa学习如何解释口头命令的方式。

根据亚马逊的早期测试,新的Inferentia集群可提供与Nvidia T4芯片相同的结果,但延迟降低了25%,成本降低了30%。较低的延迟将使Alexa开发人员可以对传入数据进行更高级的分析,而无需用户等待缓慢的计算。

背景故事

亚马逊两年前推出了Inferentia处理器产品线,旨在最大程度地提高公司人工智能工作负载的处理速度,同时通过减少芯片设计过程中的中间人来节省成本。原始设计来自于2015年被亚马逊收购的专业芯片设计师Annapurna Labs。

Alexa并不是第一个依靠Inferentia支持的Inf1 AWS实例的Amazon产品。亚马逊的面部识别工具Rekognition也正在转移到Inf1实例。AWS客户还可以自由使用Inf1和Inferentia进行自己的项目。例如,Snapchat的母公司Snap(NYSE:SNAP),健康保险巨头Anthem(NYSE:ANTM)和全球出版商Conde Nast已经在使用基于亚马逊Inferentia的神经网络实例来促进其人工智能项目。