苹果的ARKit 4引入了新的深度功能并将面部跟踪扩展到更多设备

今天下午,在苹果公司召开的2020年全球开发者大会(WWDC)主题演讲之后,该公司详细介绍了ARKit 4,这是其iOS设备增强现实(AR)应用程序开发套件的最新版本。它在Beta中可用,引入了深度API,该API创建了一种在iPad Pro上访问深度信息的新方法。位置锚定-另一个新功能-利用Apple Maps的数据将AR体验放置在iPhone和iPad应用程序中的地理位置。现在,任何配备Apple Neural Engine和前置摄像头的设备都支持对照片和视频进行面部跟踪。

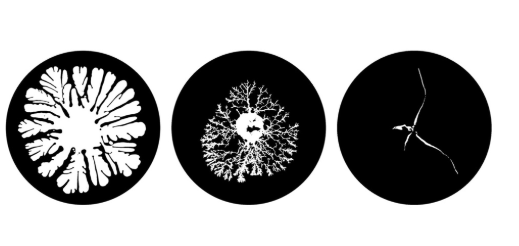

根据Apple的说法,深度API利用2020 iPad Pro的激光雷达扫描仪内置的场景理解功能来收集有关环境的每个像素的信息。与3D网格数据结合使用时,该API通过启用数字对象的即时放置并将其与周围环境无缝融合,使虚拟对象遮挡更加逼真。

至于ARKit 4的Location Anchoring,它支持在整个城市,著名地标以及其他地方放置AR体验。更具体地说,它允许开发人员将AR创建锚定在特定的纬度,经度和高度坐标上,以便用户可以在虚拟对象周围移动并从不同的角度查看它们。

关于扩展的面部跟踪,它可以在装有A12仿生芯片及更高版本的任何iOS智能手机或平板电脑上使用,包括iPhone X,iPhone XS,iPhone XS Max,iPhone XR,iPad Pro和iPhone SE。苹果表示,它能够一次追踪多达三张脸。

除了这些改进之外,ARKit 4还附带了运动捕捉功能,使iOS应用程序能够了解一系列关节和骨骼的身体位置和运动,并使用运动和姿势作为AR体验的输入。现在可以使用设备的前后摄像头同时捕获面部和世界跟踪,并可以在多个人之间协作以构建AR世界地图。任何对象,表面和角色都可以显示视频纹理。并且部分归功于机器学习驱动的改进,使用ARKit 4构建的应用程序一次可以检测多达100张图像,并可以自动估计图像中对象的物理尺寸,从而在复杂环境中获得更好的识别。

ARKit的先前版本-3月发布的ARKit 3.5-添加了新的Scene Geometry API,该API利用2020 iPad Pro的激光雷达扫描仪创建空间的3D地图,区分地板,墙壁,天花板,窗户,门,和座位。它引入了能够快速测量距离最远五米的对象的长度,宽度和深度的功能,使用户能够创建可用于对象遮挡的数字传真(即,使数字对象看起来像融合在真实对象后面的场景中) 。

ARKit 3.5在动作捕捉和人员遮挡部门也进行了改进,为人员提供了更好的深度估计,为动作捕捉提供了更好的高度估计。在2020 iPad Pro上,激光雷达扫描仪可实现更精确的三轴测量,无需更改代码即可为现有应用程序带来好处。