Facebook人工智能研究应用Transformer架构简化了对象检测模型

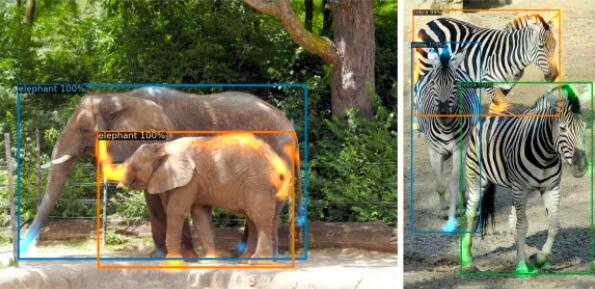

Facebook AI Research(FAIR)的六名成员利用了流行的Transformer神经网络架构来创建端到端的对象检测AI,他们声称这种方法简化了对象检测模型的创建并减少了对手工组件的需求。该模型名为检测变压器(DETR),可以一次识别一次图像中的对象。

FAIR在博客文章中表示,DETR是第一个成功将Transformer架构成功集成为检测管道中的核心构件的对象检测框架。作者补充说,变形金刚可以像近年来对自然语言进行处理一样,彻底改变计算机视觉,或者缩小NLP与计算机视觉之间的差距。

“通过将通用的CNN与Transformer架构相结合,DETR可以直接(并行)预测最终的检测结果,”周三发表的FAIR论文与DETR的开源版本一起阅读。“与许多其他现代探测器不同,新模型在概念上很简单,不需要专门的库。”

Transformer网络架构由Google研究人员于2017年创建,最初旨在作为一种改进机器翻译的方法,但已发展成为机器学习的基石,用于制作一些最流行的经过预先培训的最新语言模型,例如Google的BERT,Facebook的RoBERTa等。在与VentureBeat的对话中,谷歌AI负责人Jeff Dean和其他AI知名人士宣布,基于Transformer的语言模型是2019年的主要趋势,他们预计将在2020年继续发展。

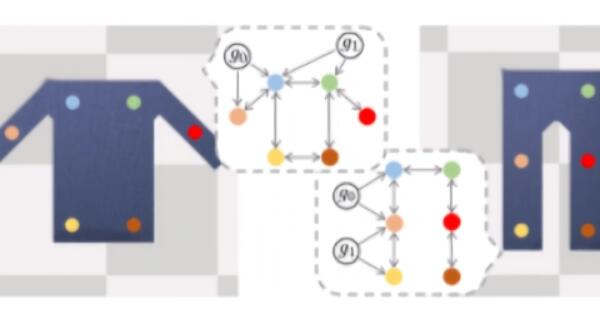

变压器使用注意力函数代替递归神经网络来预测序列中的下一步。应用于物体检测时,Transformer可以削减建立模型的步骤,例如需要创建空间锚点和自定义图层。

据arXiv称,DETR的结果可与Faster R-CNN媲美,后者是由Microsoft Research创建的对象检测模型,自2015年推出以来,该模型已获得近10,000次引用。DETR研究人员使用COCO对象检测数据集以及与全景分割有关的其他数据集进行了实验,全景分割是绘制图像区域而不是使用边界框的对象检测类型。

作者说他们遇到的一个主要问题是:DETR在大对象上比在小对象上工作得更好。“目前的检测器需要几年的改进来处理类似的问题,我们期望未来的工作能够成功地为DETR解决这些问题,”作者写道。

DETR是最新的Facebook AI计划,旨在寻找一种语言模型解决方案来解决计算机视觉挑战。本月早些时候,Facebook引入了仇恨模因数据集和挑战,以支持创建能够识别模因中的图像和随附文本何时违反Facebook政策的多模式AI。在相关新闻中,本周早些时候,《华尔街日报》报道说,一项内部调查于2018年得出结论,Facebook的推荐算法“利用人脑对分裂的吸引力”,但高管们很大程度上忽略了这一分析。